Usare le automation per le notizie sugli scioperi

Sapevate che oggi a Milano e Roma ci sono scioperi dei mezzi? Sì, se vivete in quelle città, no se arrivate da fuori. E c'è un modo per ottenere queste informazioni per tempo grazie alle AI

Hola,

Sono Barbara D’Amico, giornalista, head of project management team per un’azienda italiana della comunicazione e fu Google News Lab Teaching Fellow. Questa è la mia newsletter sul digital journalism, un modo per restare in contatto con me, sapere cosa combino e ricevere news su corsi, eventi e punti di vista fondamentalissimi su quanto accade nell'infosfera online.

Prima di iniziare, vorrei dare il benvenuto ai nuovi iscritti e alle nuove iscritte o semplici follower. La stragrande maggioranza arriva grazie alla “raccomandazione” fatta da un’altra newsletter, quella dell’esperto di risorse umane e lavoro Osvaldo Danzi (la potete leggere qui).

Il sistema di recommendation di Substack funziona come un volano. E’ il design della app a renderlo semplice da usare perché è innestato nel funnel o flusso di azioni che dal click iniziale sulla piattaforma portano all’azione finale (es. iscrivermi a un’altra newsletter oppure rilanciare un contenuto che ho letto) con pochissimi passaggi intermedi. In gergo tecnico si dice che la app ha una UX/UI estremamente efficaci.

Funziona così: se chi ti legge su Substack ti apprezza al punto da voler dire al suo pubblico - follower oppure abbonati - “ehi, guarda che Tizia/Caio scrive cose che potrebbero interessarti”, può pubblicizzare la cosa in modo gratuito ospitando l’icona della tua newsletter sul suo profilo.

E’ una leva di crescita che fa bene sia a chi raccomanda sia a chi viene raccomandato perché evita la creazione di bolle o profili troppo di nicchia.

L’idea replica il meccanismo del marketing collaborativo, pratica grazie a cui due o più brand si aiutano nello sponsorizzare vicendevolmente l’altro marchio presso il proprio pubblico.

La differenza è che il co-branding o co-marketing qui su Substack è libero e non biunivoco: non c’è un obbligo di raccomandare chi ci ha già promosso. Inoltre, se il contenuto è davvero in linea con i possibili gusti del pubblico, il raccomandante ci guadagnerà in autorevolezza. In affidabilità. E chi viene raccomandato potrà guadagnare a sua volta nuovi follower.

Con un ma: chi magari legge o segue una certa pubblicazione, potrebbe non trovare cose interessanti su quella consigliata e disiscriversi dopo aver ricevuto la prima newsletter. Non bisogna quindi fare troppo affidamento sulle recommendation pensando siano sinonimo di abbonati facili. La vera ricchezza dei content creator - giornaliste/i e non - è nella famosa base Super Fan di cui ho già scritto qui:

Vedere persone appena abbonate mollare il colpo è il rischio dei cross-target. Un rischio che però ci accolliamo con molto piacere.

Ironia 1: la mia primissima newsletter, quando ancora non esisteva Substack, si chiamava The Italian Job e ogni settimana proponeva il meglio delle news sul mondo del lavoro.

Ironia 2: il numero di oggi in un certo senso c’entra anche con il lavoro. Quindi, cominciamo.

La giungla delle news sugli scioperi

Come accade a chiunque viva in una città diversa da quella in cui nasce, anche io mi affido ai viaggi in treno per vedere la mia famiglia e viceversa.

Dati i continui ritardi e scioperi, prima di prendere o far prendere i biglietti spesso sbircio il mitico portale degli scioperi del Ministero dei Trasporti che raccoglie tutte le proteste del settore, non solo del personale ferrovie, in Italia. Consultandolo, si evita di prenotare proprio nei giorni dei blocchi.

Il sito è una miniera di informazioni gratuite, pubblicate in una comoda tabella filtrabile e aggiornata. Esiste perché, per legge, gli scioperi vanno comunicati dalle sigle o organizzazioni sindacali che li indicono.

Però è poco divulgativa, poco godibile, e soprattutto nessuno si sveglia la mattina pensando “dai, fammi inserire il link del mit per vedere chi sciopera oggi”.

Anche se è da questa fonte - oltre che dai comunicati stampa sindacali - che i giornali prendono le informazioni per scrivere i pezzi sulle proteste, per ragioni di tempistiche editoriali è raro che le redazioni facciano articoli settimane prima dello sciopero stesso. Morale: noi che dovremmo avere queste informazioni tempestivamente, spesso caschiamo dalle nuvole con relativa arrabbiatura e stress.

E allora perché non creare delle notifiche automatiche con il riassunto dei prossimi scioperi non appena il file del Ministero dei Trasporti si aggiorna?

Anni fa mi era venuta anche l’idea di creare una mappa aggiornata degli scioperi. La mappa forse la farò ma oggi proviamo insieme a creare il recap automatico via mail dei principali scioperi in arrivo. E’ qualcosa che oggi di può mettere in piedi con strumenti (quasi) gratuiti online.

C’entrano le intelligenze artificiali e il numero della newsletter di oggi parte da un’esigenza molto concreta per fare una riflessione più generale su come (non) ci formiamo per usare le AI e come il nostro “training” stia influenzando il modo in cui le raccontiamo sui giornali e in tv.

Veniamo ai nostri scioperi quotidiani: per avere la sintesi, possiamo sfruttare le cosiddette automation.

Cosa sono le automation

Si tratta di una serie concatenata e automatizzata di azioni digitali. Se voglio creare una sintesi via mail degli scioperi attivi in Italia posso legare tra loro:

la pagina con l’elenco degli scioperi aggiornati dal Ministero dei Trasporti;

un motore AI che sintetizzi le informazioni prese dalla pagina - ad esempio ChatGPT, Claude o Gemini;

Gmail o un altro provider di messaggi per l’invio della sintesi via mail.

Il tutto impostando le regole una sola volta.

Per farlo però non basta chiedere al nostro assistente “creami il recap e inviamelo via mail”. Serve qualche passaggio in più, anzi servono delle concatenazioni.

Ho deciso di usare una piattaforma che fa proprio questo: crea automation legando insieme più tool già disponibili online ognuno dei quali svolge un’azione precisa.

Si chiama Zapier, è sul mercato da un bel po’ e fa parte di quelli che io definisco “bridge tool” o strumenti-ponte, cioè tutti quei tool digitali nati dopo l’exploit di ChatGPT con lo scopo di facilitare l’utilizzo dei motori conversazionali per chi, come me, non sviluppa codice (ce ne sono a migliaia in giro e alla fine della newsletter trovate qualche info in più).

Ecco cosa ho fatto (spoiler, quello che ho ottenuto è un primo modello demo non ancora perfetto e che mi ha richiesto diverse ore di lavoro solo per capire quali passaggi fare). Al momento non riesco ancora a ottenere la sintesi che vorrei e con più informazioni condensate nella stessa mail, ma la base.

In questa mail ad esempio il 21 febbraio venivo avvertita di uno sciopero di 24 ore del trasporto pubblico locale che ci sarà il 9 marzo a Napoli: quindi con un congruo preavviso per organizzarmi nel caso dovessi viaggiare in quella città:

I passaggi

Step 1 > Ho chiesto a ChatGPT di spiegarmi i passaggi tecnici per creare un flusso automatico dal sito del MIT alla mia mail (non avevo ancora in mente di usare Zapier, me lo ha suggerito il motore). Ecco il prompt che ho usato:

“Vorrei creare un automation che, partendo da un link feed rss, fosse in grado di:

1) estrarre le informazioni dal feed

2) sintetizzare quelle informazioni in un breve recap news basato sulle informazioni trovate nel link feed

3) spedire questo recap via mail”

Il feed rss altro non è che il link del contenitore di una pagina web, dei suoi campi “fissi” per intenderci, come la sezione in cui compare il testo di un articolo o una foto, oppure la data. Non è il contenuto di quella pagina.

Nel nostro esempio, è il link che si trova sulla pagina del MIT (c’è proprio scritto rss) e che useremo come fonte da cui pescare le informazioni da sintetizzare:

Per spiegarvi però come funziona il feed e perché non possiamo usare il normale link della pagina per l’esperimento, completo con una brevissima definizione da un vecchio numero della newsletter:

“Cos’è il feed rss? E’ quell’invenzione a cui ha contribuito per prima la mente meravigliosa di Aaron Swartz e che permette di far arrivare i contenuti pubblicati su un sito, su un supporto diverso. In questo modo, anziché dover consultare attivamente 10 siti diversi, posso dire “ehi, quando qualcuno aggiorna la home page o la sezione di cui ho il feed rss, per favore fammi arrivare anche titolo, sommario , link, data ecc… qui sul mio foglio di calcolo o altrove”. Qualunque sito o canale podcast o video ha praticamente un feed rss.”

Potete prendere il mio tutorial per creare dashboard con tutte le news usando solo feed rss qui:

Step 2 > Torniamo al prompt: GPT mi ha proposto di usare Zapier per creare il flusso dal link feed alla mail.

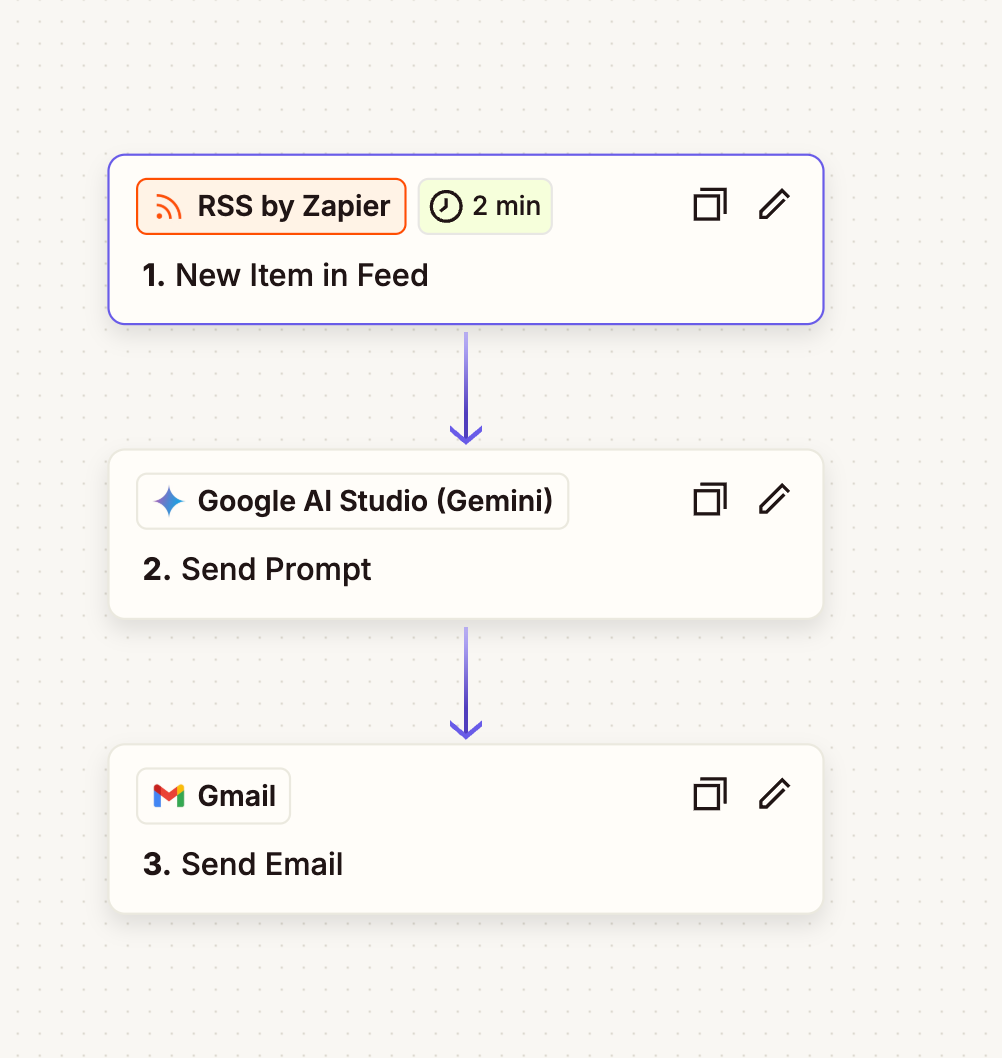

Ho aperto quindi Zapier e creato un account. Ho poi cliccato sull’icona degli Zaps - la riconoscete perché ha un fulmine arancione. Gli zaps sono in sostanza i pacchetti di automation che possiamo creare. Cliccando sull'icona si apre una specie di pagina bianca, un progetto, in cui creare una concatenazione come questa:

I passaggi sembrano lineari, ma se non avessi avuto le istruzioni di ChatGPT a guidarmi forse avrei impiegato giorni.

Momento nerd: la prima concatenazione infatti non era così, non partiva dal tool RSS di Zapier, ma da un altro tool, Google Spreadsheet, e aveva come fonte un foglio di calcolo google su cui avevo fatto arrivare il feed rss con l’elenco degli scioperi.

Questo semplicemente per avere maggior controllo sul numero di aggiornamenti che avrei potuto far “pescare” dall’automatismo, dedicendo io dal foglio quante righe far aggiornare. Questa impostazione però non ha funzionato e GPT mi ha suggerito di partire direttamente dal link del MIT come fonte.

Nel sistema attuale, quindi, ogni volta che sul sito del MIT viene aggiunta una riga alla tabella, una notifica parte verso la mia mail. Se il MIT aggiornasse 100 righe insieme - spero di no, per l’Italia - io mi ritroverei 100 messaggi email, non il massimo. Per ora questo rischio è scongiurato.

Step 3 > Per impostare il link rss come fonte da cui pescare le notizie sugli scioperi, ho solo cliccato sul segno + che si vede non appena si apre il progetto Zaps.

A quel punto si apre un menù da cui dovete selezionare lo strumento che legge o cattura il link rss. Io ho selezionato Feed RSS by Zapier suggerito da ChatGPT, cioè lo strumento che permette a Zapier di digerire il link feed e adattarlo all’automation.

Step 4 > cliccando su ogni blocco dell’automation si apre una finestra laterale con tutti parametri da impostare per ciascun mattoncino della nostra concatenazione.

Anche qui ho seguito per ogni voce le istruzioni di ChatGPT per velocizzare. Ad esempio, c’è sempre un “Evento” che funge da trigger. Ogni volta che il MIT aggiorna la tabella degli scioperi e quindi aggiunge una riga (New Item in Feed), questo innesca la concatenazione:

Step 5 > Ogni blocco dell’automation è composta di tre fasi: Setup, Configurazione e Test.

Per far arrivare le informazioni caricate sul sito del MIT direttamente a un motore AI come Gemini - che ci serve per creare una piccola news con le info di base del nuovo o dei nuovi scioperi - ho dovuto indicare quali colonne e quali informazioni della tabella del MIT pescare precisamente per la sintesi. Vengono suggerite automaticamente, basta selezionarle

Tranne che per il primo strumento - Feed RSS by Zapier - ho dovuto, ovviamente, collegare a Zapier i miei account Gmail e Gemini e ho attivato un piano a pagamento di Zapier (in realtà ho una settimana gratuita) perché le interrogazioni costano e non basta un piano gratuito.

Almeno, io non sono riuscita a impostarlo in questo modo ed è sicuramente un mio limite. Il costo, in ogni caso, è gestibile.

Step 5 > A quel punto ho testato il flusso e mi sono fatta arrivare una mail di test (in realtà i test sono stati decine, ho la casella invasa!) e una volta ritenutami soddisfatta ho cliccato su tasto RUN di Zapier.

P.S. potete mettere in pausa in qualunque momento l’automation creata.

Qualche riflessione

L’uso dell’AI non è ancora alla portata di tutti. Non per ragioni economiche, ma di competenze. E’ anche vero che il supporto di ChatGPT è stato davvero fondamentale e semplice nelle istruzioni da seguire.

Se il tempo di impostazione di un flusso simile è comunque minore di quello che dovremmo impiegare ogni giorno per controllare se ci sono nuovi scioperi, prendere le informazioni e sintetizzarle e inviarle, vale la pena investire qualche ora.

Nelle redazioni ad esempio un sistema simile può essere usato per lanciare una ricerca con i feed rss su tutte le fonti online specializzate - penso al feed rss delle fonti governative con gli aggiornamenti sulle elezioni o a fonti come i siti sportivi quando ci sono i risultati delle partite - far condensare quei risultati in un riassunto comprensibile e farlo inviare in automatico via mail ai giornalisti o direttamente nel content management system in modo che possano controllarlo.

Oppure per costruirci una newsletter a pagamento per chi vuole ricevere aggiornamenti, analizzati in grande quantità e in tempi accettabili. Lavori che richiederebbero ore possono quindi essere fatti “in background” da un insieme di concatenazioni.

Invece, in Italia ci divertiamo a fare ancora i pezzi su “ho chiesto all’AI di dirmi chi sono e mi ha risposto con cose inventate”.

E’ come se un giornalista, appena messa sul mercato la macchina da scrivere Olivetti, l’avesse criticata “perché ho provato a disegnarci e mi lascia solo dei segni di inchiostro senza senso sul foglio bianco”. Ecco, come la macchina da scrivere non serviva a disegnare - pur avendo inchiostro e comandi - così i large language models non servono a dirti chi é chi (almeno, non è questo il modo di chiederlo).

Farci aiutare in processi logici più complessi, come quelli che creano un automatismo, credo sia invece il modo corretto di usare strumenti di intelligenza artificiale. Ne avevo parlato anche in una intervista rilasciata a Cristiana Bedei per l’International Journalist’s Network sull’avvento dei cosiddetti e già citati strumenti-ponte. Ovvero, piattaforme (come Zapier) che servono a chi come me non sa scrivere codice, per sfruttare le AI facendole “parlare” con altri strumenti di uso comune.

In quell’articolo spiegavo che le piattaforme come ChatGPT non avrebbero stravolto la vita di chi fa informazione, per il semplice fatto che la nostra categoria non ha ancora le competenze e la preparazione sufficienti per poterne davvero sfruttare il potenziale.

Un vantaggio competitivo posseduto invece da sviluppatori, artisti digitali e altre categorie, per la connaturale capacità di imparare attraverso una diffusa condivisione e un costante confronto. Github ma anche Reddit, per esempio, sono solo due delle piattaforme collaborative in cui si impara per osmosi e grazie all’open source.

Nel giornalismo classico (generalizzo anche se ci sono felici eccezioni) invece vige ancora una grande rigidità e chiusura nella formazione e purtroppo poca elasticità nella creazione di team misti (con sviluppatori, designer, analisti in pianta stabile): cosa che negli anni si è dolorosamente scontrata con l’evoluzione tecnologica e con una necessità di apprendimento diffusa e non più solo centralizzata.

Detto altrimenti: oggi diventa più performante con le AI chi ha già più formazione sul loro uso o sull’uso degli strumenti-ponte, e chi accetta nei propri team professionalità molto diverse ed eterogenee rispetto a chi fa informazione.

La formazione è la lente con cui guardare le trasformazioni tecnologiche in atto. Più si è formati sull’uso della macchina, meno si è sostituibili dalla macchina. E forse dovremmo anche smetterla di ragionare solo in termini di contrapposizione uomo-macchina e velocizzare l’apprendimento e le applicazioni intelligenti degli strumenti AI.

E’ un cambio di prospettiva che credo sia necessario per evitare di usare la tecnologia a sproposito perdendo treni che al prossimo giro saranno troppo veloci anche solo per pensare di salirci a bordo.

Tool

A proposito di tecnologica vi lascio qui qualche elenco utile:

Elenco di tool e motori generativi AI (Github)

Elenco di tool e motori generativi AI (Harvard)

Io vi saluto e vi do appuntamento al prossimo numero.

Osvaldo Danzi ti vuole bene anche se non lo consideri! :)